これまでの取り組み

眼球ロボットによるコミュニケーション どのような動きが人間に理解されるのか?どのように行動すれば人間が理解できるのか?

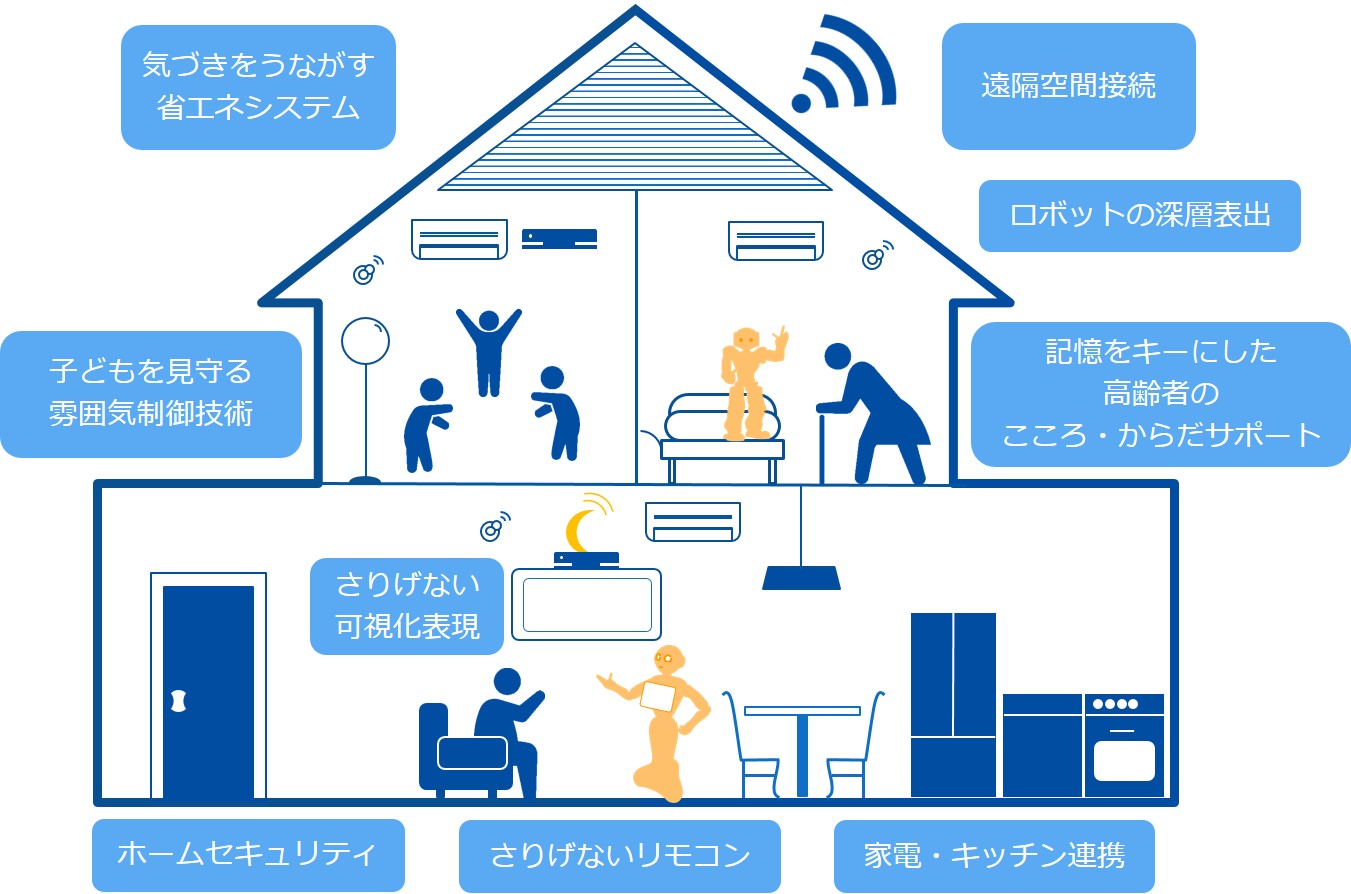

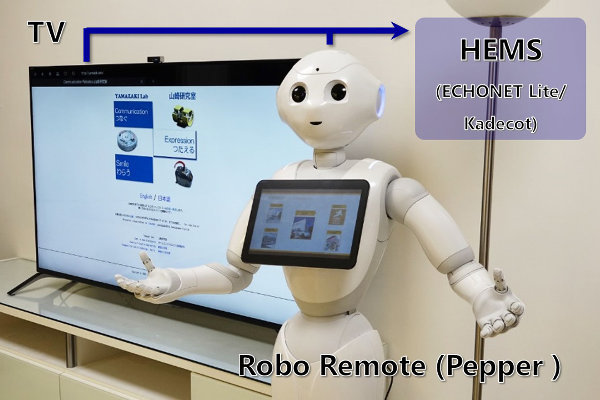

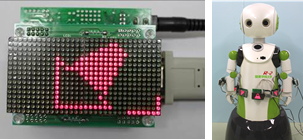

環境配置型ネットワークロボットによるさりげないアシスト

生活環境でロボットがさりげなく人間をアシストするためには、人間を理解する必要があります。音声、画像をから人間の行動を認識し、人間をさしげなくアシストするマスコットロボットシステムの研究を行います(東京工業大学廣田研との共同研究)。

親和性ロボット表出要素 共感アンテナAHOGE

人真似でないロボット独自表現とはどうあるべきか?姿勢要素を考慮した触角型ロボット表出である共感アンテナAHOGE(Antenna Hair-Type Object for Generating Empathy)。ロボットによる親しみ表出技術を機能化、要素化し、人と接するシステム全般へ実応用を目指します。

VIDEO

全方向移動体のための行動表出

ロボットとして様々な環境へ進出しつつある全方向移動体。人間とは異なるロボット特有の行動を,周囲の人間にわかりやす伝える行動表出装置Omni-Winkerを開発します(大阪大学多田隈助教との共同研究)。

人形によるさりげない表出 ロボットがより親密な存在になるためには,動きだけでなく外見も重要です。球体関節人形を用い、愛らしさを生かしたコミュニケーションロボットを開発します。